В приведенной ниже статье мы будем с вами подробно рассматривать использование файла роботс.тхт. Многие из вас слышали о нем, кто-то знает, кто-то уже использует. Однако далеко не все знают о нем все, что нужно и работают с ним правильно. В этой связи мы попытаемся предоставить исчерпывающую информацию по целому ряду смежных вопросов.

С точки зрения грамотной индексации и создания карты движения поисковых роботов по сайту файл robots.txt представляет огромное значение. При этом, каждому вебмастеру необходимо знать зачем он нужен, как он работает, а также его синтаксис.

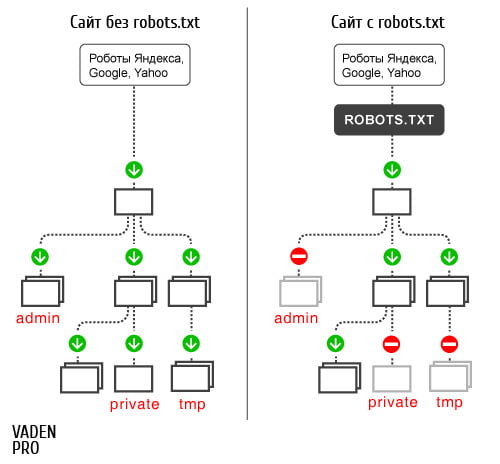

Файл robots.txt — представляет собой текстовый файл, который содержит инструкции для поискового робота и располагается в корневом каталоге сайта. Приведенные в файле инструкции имеют силу запрещать обращение и индексацию поисковым роботом определенных разделов веб-сайта, показывать правильное «зеркало» доменного имени, а также давать рекомендации роботу относительно соблюдения указанного временного интервала между скачиванием файлов с сервера.

Работу файла роботс наглядно можно представить при помощи картинки приведенной ниже:

агентство интернет маркетинга.

Как создать файл robots.txt

По сути, данный файл является обыкновенным текстовым документом, который можно создать при помощи блокнота и переименовать его название с «новый документ» в «robots» с расширением txt. При этом, внутри файла прописываются нужные обращения для поисковых роботов. Важно понимать, что на сервере будет располагаться один файл роботс. Т.е. от вас не требуется создавать отдельный файл под каждую конкретную поисковую систему.

Что писать в самом файле?

В том случае, если Вы не планируете закрывать от индексации какие-либо страницы, документы или разделы можно создать пустой файл роботс. В таком случае поисковый робот будет видеть и то, что файл есть, и то, что куда бы он не пошел для него везде будет гореть зеленый свет.

Другим способом с аналогичным, приведенному выше, результатом будет указать в файле следующее:

User-agent: * Disallow:

Данный текст также как и пустой файл роботс не создает каких-либо запретов к индексации сайта, а лишь показывает, что все директории и файлы открыты и могут быть просмотрены.

Как Вы уже могли увидеть, в файле следует в обязательном порядке употреблять две дерективы. Это: User-agent (призвана определить для какого именно бота предназначено ваше сообщение) и Disallow (указывает на страницу, группу страниц, папку которую индексировать нельзя).

Если в файле вы хотите обратиться ко всем без исключения поисковым роботам, то для этого в директиве User-agent вам необходимо использовать символ «*». Тогда содержимое файла роботс приобретет следующий вид:

User-agent: * Disallow: /file-vadenpro.php

Как можно заметить, данный файл несет в себе обращение ко всем роботам относительно запрета к индексации конкретного файла file-vadenpro.php.

Настройка файла robots.txt и ее особенности для поисковых роботов Google и Яндекс

Стоит отметить, что содержимое файла для этих двух поисковых систем различается. При этом, для файла, который будет воспринимать робот Яндекса обязательно наличие директивы host. Именно она позволяет избегать различных проблем связанных с индексацией зеркала сайта, а также дублирования страниц.

User-agent: Yandex Disallow: /cgi-bin Host: www.vaden-pro.ru

Также важным моментом является тот факт, что host воспринимают лишь боты Яндекс. И именно поэтому для обоюдного восприятия файла роботс обоими поисковыми системами следует разделить ваши обращения к каждой. Так:

User-agent: Yandex Disallow: /cgi-bin Host: www.vaden-pro.ru User-agent: * Disallow: /cgi-bin

Говоря о файле роботс.тхт для робота Google, то его содержимое ничем не отличается от обычной технологии написания.

Также вне зависимости от поисковой системы желательно в файле роботс указывать путь к вашему sitemap. Это позволит роботу лучше чувствовать себя на вашем ресурсе и как следствие быстрее его индексировать. Для этого в файл роботс.тхт добавляется строка:

Sitemap: /sitemap.xml

Еще одной рекомендацией непосредственно от разработчиков Гугл является то, что файл роботс не должен превышать 500 кб. Нарушение данного правила неизменно влечет за собой ошибки индексации.

Если вам понравилась статья не стесняйтесь и делитесь ей в соц.сетях, формах и сайтах. Появились вопросы или дополнения? Задавайте и пишите их в комментариях, и наша команда непременно ответит на них.